L’AI ci rende più competenti o solo più sicuri di quel che sappiamo fare? L’effetto Dunning-Kruger nell’era di Chat-Gpt

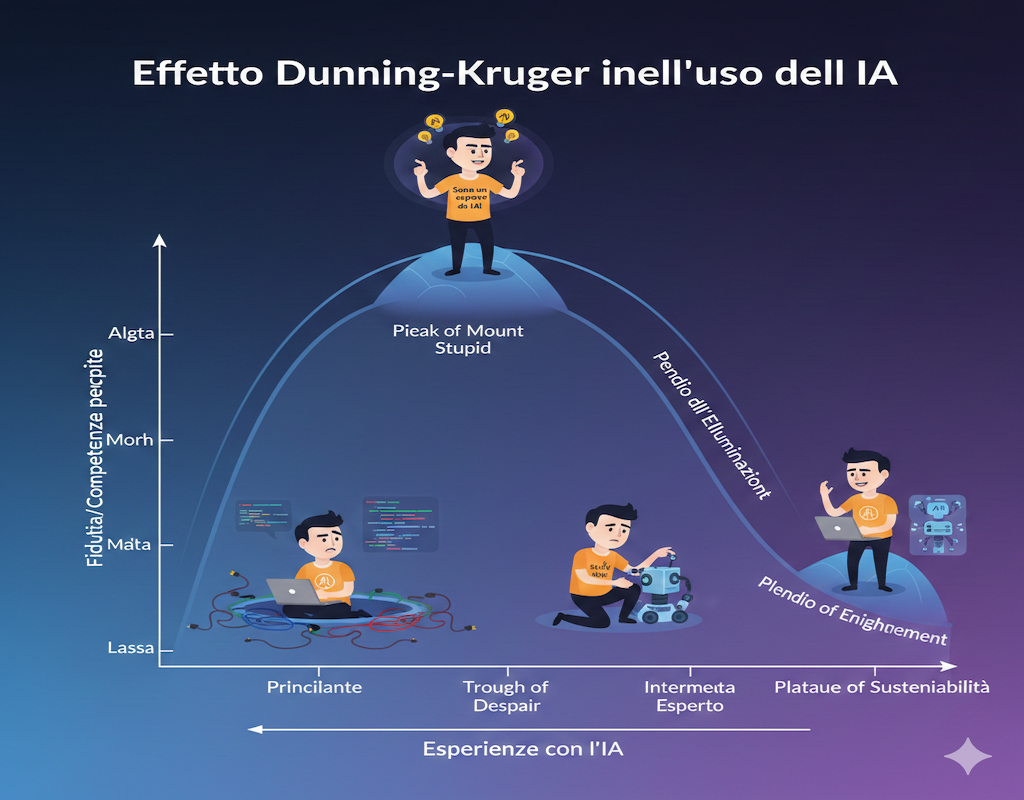

Più usiamo i Chat-Gpt, DeepSeek, Gemini, Copilot, Claude e più pensiamo di essere bravi. Non è una sensazione, ma la conclusione netta di una ricerca scientifica che getta una luce inquietante sulla nostra relazione con l’Intelligenza Artificiale. L’utilizzo dell’Intelligenza Artificiale aumenta l’effetto Dunning Kruger ovvero la percezione che per cui pur essendo meno competenti su una materia, tendiamo a credere il contrario. Quella che doveva essere una leva per potenziare le nostre capacità rischia di trasformarsi in uno specchio distorto, che altera la percezione che abbiamo di noi stessi.

Sembra la perfetta evoluzione digitale del noto effetto Dunning-Kruger, quel bias cognitivo per cui chi è meno competente tende a sopravvalutare le proprie abilità. Ma con l’AI le cose si fanno più complesse e pericolose, evidentemente anche per il mondo del posizionamento dei siti web.

Prestazioni migliori con l’IA, ma consapevolezza peggiore

Il gruppo di ricerca coordinato da Luís M. Fernandes, in uno studio pubblicato su Computers in Human Behavior dal titolo emblematico “L’intelligenza artificiale ti rende più intelligente, ma non più saggio“, ha sottoposto dei volontari a test cognitivi (ragionamento, logica) con e senza il supporto di ChatGPT.

I risultati sono stati chiari, chi usa l’Intelligenza Artificiale migliora le prestazioni ma peggiora la consapevolezza. Infatti l’effetto ha rilevato che:

- l’utilizzo dell’IA migliora le prestazioni oggettive;

- peggiora, però, la percezione soggettiva delle proprie capacità.

In pratica, la macchina ci fornisce risposte migliori, ma ci rende meno consapevoli dei nostri limiti. Otteniamo un risultato di qualità, ma attribuiamo a noi stessi un merito che non è totalmente nostro, finendo per sopravvalutarci.

Addio curva a U, benvenuta fiducia piatta

Il classico schema del Dunning-Kruger che è rappresentato da una curva a U rovesciata, in cui i principianti si sopravvalutano e gli esperti si sottovalutano, scompare. Nell’interazione con l’AI, al suo posto, compare una linea piatta di fiducia eccessiva nelle proprie capacità.

Tutti i partecipanti, indipendentemente dalla loro reale competenza, credevano di essere sopra la media. Il fenomeno è stato battezzato “metacognitive decay” ovvero l’erosione della capacità di valutazione delle proprie competenze e il decadimento della consapevolezza di sé (e delle capacità di autovalutazione).

Il paradosso: più sei “esperto” di AI, meno ti accorgi di sbagliare

La scoperta più sorprendente? Il fenomeno è più marcato proprio tra coloro che si dichiarano competenti in intelligenza artificiale. Più siamo familiari con la tecnologia, meno siamo capaci di giudicare criticamente se l’output che produciamo con il suo aiuto sia davvero valido. Si tratta del fenomeno della “fiducia piatta” e dell'”automation overconfidence”. L’utilizzo dell’IA induce un eccesso di fiducia sia in esperti che in principianti, senza alcuna distinzione tra i 2 soggetti.

I ricercatori lo spiegano con un’immagine potente: l’AI è come un paio di occhiali che corregge la vista ma tinge tutto di una luce artificiale. Vediamo meglio, ma siamo portati a credere di vedere perfettamente ed è fin fenomeno che coinvolge anche gli “esperti” di ogni materia e argomento.

L’illusione di competenza algoritmica

NeuroscienceNews, riprendendo lo studio, parla di “illusione di competenza algoritmica”. Cosa significa? Più un’AI fornisce risposte coerenti, fluide e linguisticamente convincenti, più la nostra mente tende a confondere la fluidità dell’output con la correttezza del contenuto.

È lo stesso bias che ci porta a fidarci ciecamente di un discorso ben scritto, anche quando è pieno di errori concettuali. Ci affidiamo alla forma, trascurando la sostanza.

Automation overconfidence: Il nuovo rischio professionale

L’impatto pratico di questo fenomeno non è teorico. In contesti ad alto rischio come la diagnosi medica, la finanza o l’analisi legale, questo eccesso di fiducia indotto dall’AI – già chiamato “automation overconfidence” – può portare a:

- Decisioni affrettate.

- Verifiche insufficienti.

- Errori critici dovuti a una delega acritica alla macchina.

I rischi dell’uso dell’AI nelle decisioni professionali si è già evidenziato con i casi degli avvocati che hanno affidato all’IA l’analisi delle sentenze poi portate in giudizio e rivelatesi false. Con l’IA creiamo una società di utenti mediamente più competenti, ma anche più sicuri di sé in modo ingiustificato e, quindi, più vulnerabili all’errore.

La soluzione non è meno AI, ma un AI più consapevole

La risposta, concordano gli esperti, non è demonizzare o ridurre l’uso dell’intelligenza artificiale. La strada è ripensare il modo in cui la integriamo nel nostro lavoro e nel nostro apprendimento.

Dobbiamo:

- Insegnare il pensiero critico: Educare gli utenti a interrogare l’AI, a verificarne le risposte e a comprendere i suoi limiti.

- Progettare per la trasparenza: Spingere per lo sviluppo di AI che mostrino il proprio “ragionamento” e il grado di affidabilità delle informazioni fornite.

- Promuovere l’auto-verifica: Incorporare nei flussi di lavoro dei momenti obbligati di verifica e riflessione autonoma, prima di considerare definitivo un output generato dall’AI.

L’obiettivo non è fermare il progresso, ma evitare che l’intelligenza artificiale, nata per potenziare la nostra mente, finisca per offuscare la nostra più grande dote: la consapevolezza di ciò che non sappiamo.